Microsoft introduce i modelli Meta Llama 3 nel catalogo dei modelli di Azure AI. I nuovi modelli offrono migliori performance e nuove funzionalità.

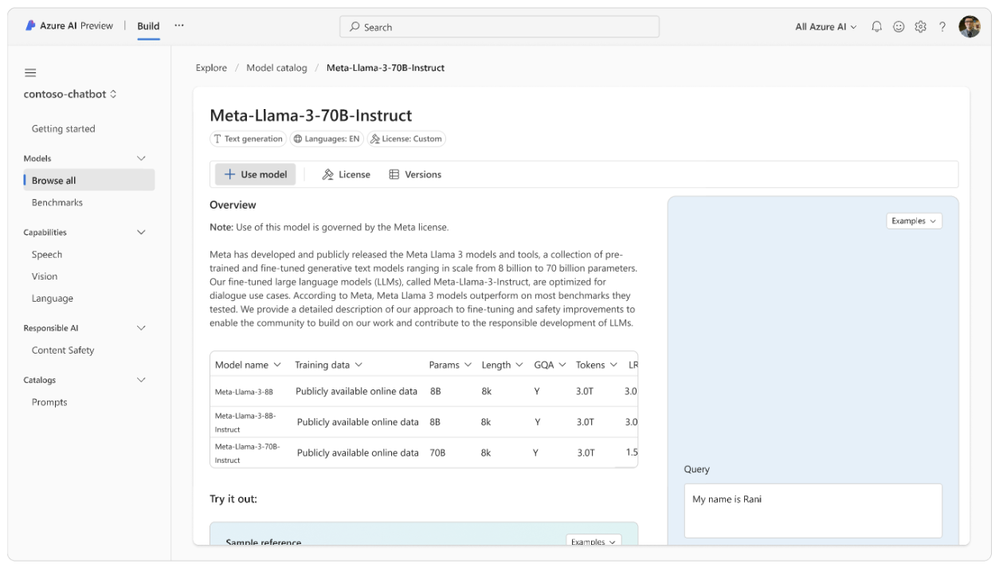

In collaborazione con Meta, Microsoft ha presentato i modelli Meta Llama 3 in Azure AI. I modelli Meta-Llama-3-8B-Instruct e Meta-Llama-3-70B-Instruct, precursore e addestrati, rappresentano la prossima generazione di Grossi Modelli Linguistici (LLM) di Meta Llama, ora disponibili nel catalogo dei modelli di Azure AI.

Allenati su una grande quantità di dati di preaddestramento, i modelli Meta Llama 3 consentono ai sviluppatori di ottimizzare le prestazioni complessive. Microsoft è lieta di essere partner di lancio di Meta e supporta gli sviluppatori con strumenti popolari come il flusso di invito di Azure AI e LangChain.

Novità nei modelli Meta Llama 3

I modelli Meta Llama 3 includono modelli linguistici preaddestrati e addestrati per gestire un’ampia gamma di casi d’uso. Meta ha rilevato miglioramenti significativi e avanzate funzionalità nei benchmark standard del settore, come migliorate capacità di ragionamento.

Meta ha segnalato notevoli miglioramenti alle procedure di post-addestramento, portando a una considerevole riduzione dei tassi di rifiuto errati e a miglioramenti nell’allineamento e nella diversità delle risposte del modello. Secondo Meta, queste modifiche hanno notevolmente migliorato le capacità di Llama 3. Llama 3 mantiene la sua architettura transformer solo per il decoder ma include ora un tokenizer più efficiente che migliora notevolmente le prestazioni complessive.

Caratteristiche dei modelli Meta Llama 3:

- Maggiore numero di token di addestramento (15T): permette ai modelli Meta Llama 3 di comprendere meglio le sfumature del linguaggio.

- Finestra di contesto estesa (8K): raddoppia la capacità di Llama 2, permettendo al modello di accedere a più informazioni da passaggi lunghi per prendere decisioni informate.

- Un nuovo tokenizer basato su Tiktoken con un vocabolario di 128K token: codifica più caratteri per token. Meta segnala una migliore performance sia nei test di benchmark in lingua inglese che multilingue, rafforzando le sue robuste capacità multilingue.

Utilizzo dei modelli Meta Llama 3:

- I modelli preaddestrati e addestrati nelle istruzioni di Meta-Llama-3-8B sono consigliati per scenari con risorse computazionali limitate, offrendo tempi di addestramento più rapidi e idoneità per dispositivi edge. Sono adatti per casi d’uso come la sintesi del testo, la classificazione, l’analisi del sentimento e la traduzione.